Sumo Logicを出展~Japan IT Week 秋

- On 2021年11月10日

Sumo Logicはあらゆるプラットフォームから収集したログのリアルタイム分析・管理、セキュリティ監視を実現するプラットフォームです。当日の弊社ブースには、DXに備えたマルチクラウド・ハイブリッド環境でのセキュリティに強い危機感をお持ちの、金融や公共機関を含むたくさんのお客様が、多数来訪されました。短いお時間でしたが、弊社からはSumo Logicのコンセプトと同時に出展していたPagerDutyやRundeckといったインシデント対応ツールとの連携についてご説明させていただきました。

さらなるご説明を要望されたお客様には個別にコンタクトさせていただき詳細をお伝えいたします。

(弊社Facebookページで当日の写真をごらんいただけます。)https://www.facebook.com/DigitalStacksCorporation

なお、Digital StacksではSumo Logicの導入の操作を解説した「Sumo Logic スタートガイドブック」を無料プレゼント中です。ご興味のある方はぜひご覧ください。

Sumo Logic スタートガイドブック

https://sumologic.dxable.com/readme-japan-it-week-autumn-2021

■Sumo Logic:総合ログ管理の自動化

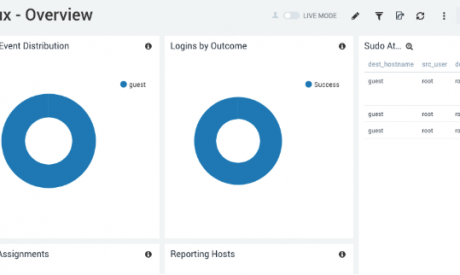

オンプレミス&マルチクラウド対応で各拠点からのログ収集を自動化し、イベントとログの相関分析の結果をダッシュボードに表示します。面倒な収集と分析を自動化することでデータ駆動型の意思決定が可能になり、セキュリティへの脅威や障害を迅速にとらえることができます。既にSIEM(Security information and event management)の要として国内外で2100社を超える企業が採用しています。

Digital Stacksでは、このほかにも企業の方のデジタルトランスフォームを支援する製品・サービスを取り扱っておりますので、ぜひこの機会に海外の新しいテクノロジーにご興味をお持ちの方は弊社までお問い合わせください。

■展示会情報

名称:第12回 Japan IT Week 秋

会期:2021年10月27日(水)~29日(金)

会場:幕張メッセ

主催:RX Japan株式会社 (旧社名: リード エグジビション ジャパン)

公式HP:https://www.japan-it-autumn.jp/ja-jp.html

■株式会社Digital Stacksについて

株式会社Digital Stacksは、欧米を中心とした世界の最新クラウドテクノロジー製品をいち早く発掘して日本国内の法人のお客様に提供しています。全ての企業と企業人のデジタルトランスフォーメーションの加速をサポートし続けます。

本社所在地: 〒141-0001 東京都品川区北品川5-5-15 大崎ブライトコア4階SHIP 414号室

代表取締役CEO: 島田憲治

事業開始: 1995年3月

URL: https://www.digitalstacks.net/

本リリースに関するお問い合わせは

広報担当:内海彩加 info@digitalstacks.net

までご連絡ください。

当社のブースにお立ち寄りいただくだけで、新世代のソフトウェア開発・運用監視・障害対応・各種業務の自動化ツールとプラットフォームについての情報を得られます。また、来場者限定で、各製品のスタートガイドブックなどを無料でプレゼントいたします。是非ご来場ください。

Sumo Logic:総合ログ管理の自動化

オンプレミス&マルチクラウド対応で各拠点からのログ収集を自動化し、イベントとログの相関分析結果をダッシュボードに表示します。面倒な収集と分析を自動化することでセキュリティへの脅威や障害を迅速にとらえることができます。SIEMの要として国内外の企業に広く使われています。

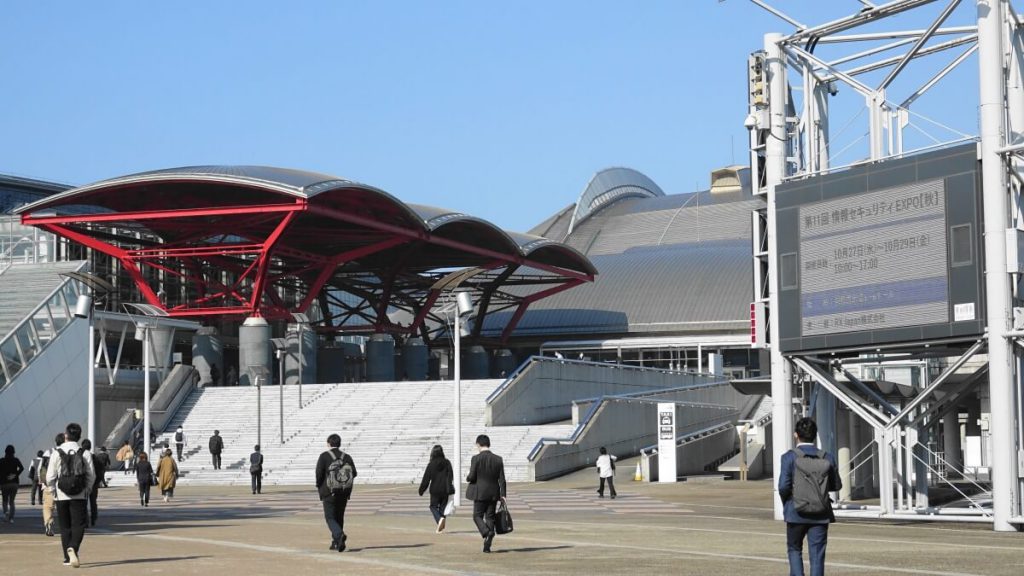

■展示会情報

『Japan IT Week 秋』(10月27日~29日、幕張メッセ) は日本最大のIT展示会です。今回も400社が出展する予定であり、ITの各分野を幅広く網羅して開催することで、ビジネス拡大を求める出展社、来場者にとって欠かせない展示会となっています。出展ブースでは製品・サービスの販売・受注、課題についての相談、見積り・導入時期の打合せなどが行われ、“実質的な商談の場”となっています。

名称:第12回 Japan IT Week 秋

会期:2021年10月27日(水)~29日(金)

時間:10:00~17:00

会場:幕張メッセ

主催:RX Japan株式会社 (旧社名: リード エグジビション ジャパン)

公式HP:https://www.japan-it-autumn.jp/ja-jp.html

入場には招待券が必要です。(招待券をお持ちでない場合、入場料¥5,000/人)

弊社から無料の招待券をお配りしていますので、下記URLよりダウンロードしてご利用ください。

e招待券URL

https://www.japan-it-autumn.jp/ja-jp/exhibit/ex_e_inv/aso.html?co=ml_aso-a-56spqg

■株式会社Digital Stacksについて

株式会社Digital Stacksは、欧米を中心とした世界の最新クラウドテクノロジー製品をいち早く発掘して日本国内の法人のお客様に提供しています。全ての企業と企業人のデジタルトランスフォーメーションの加速をサポートし続けます。

本社所在地: 〒141-0001 東京都品川区北品川5-5-15 大崎ブライトコア4階SHIP 414号室

代表取締役CEO: 島田憲治

事業開始: 1995年3月

URL: https://www.digitalstacks.net/

本リリースに関するお問い合わせは

広報担当:内海彩加 info@digitalstacks.net

までご連絡ください。

クラウドを利用して仕事をする組織はますます増えています。どのようなクラウドモデルを採用するかは、企業のビジネスモデルによって異なります。クラウドサービスの最も一般的な導入モデルは、SaaS(Software-as-a-Service)、PaaS(Platform-as-a-Service)、IaaS(Infrastructure-as-a-Service)の3つです。

ここでは、これらのクラウドモデルの違いと、組織に適したモデルを選択する際に考慮すべき点について説明します。また、これらの導入モデルを管理する際に、Sumo Logic がどのように役立つかをご紹介します。

SaaS(Software as a Service)とは、インターネットを利用して、サードパーティのベンダーが管理するアプリケーションをユーザーに提供することです。

SaaSは、サードパーティによりインターネットを介して、すべてのクライアントに直接に機能が提供されます。ソフトウェアのメンテナンスはサードパーティがリモートで行います。

ベンダーがリモートでインストール、設定、メンテナンスを行うため、クライアントのIT部門は、事業に関わるより重要な問題に時間を割くことができます。これは時間の節約だけでなく、コストの節約にもつながります。

SaaSアプリケーションは、インターネットを介してアクセスすることができます。これらのアプリケーションは集中管理され、リモートサーバにホストされています。必要なハードウェアとソフトウェアの設定は、ユーザーではなくベンダーが責任を持って行います。

第一に、SaaSはソフトウェアを管理する時間がない企業、例えばスタートアップ企業にはメリットがあります。

第二に、SaaSの導入方法は、Webやモバイルからアクセスできるアプリケーションが必要な場合に非常に適しています。また、日常的に使用しないアプリケーションにもお勧めです。

最後に、SaaSはサブスクリプション型のため、短期間だけ特定のアプリケーションが必要な場合に適しています。

SaaSの導入モデルを使用する際には、いくつかの制限や懸念事項があります。まず、ベンダーロックインが発生する可能性があります。SaaSアプリの習得は簡単かもしれませんが、他のSaaSアプリに移行する際には、データのポータビリティに大きなコストがかかることに注意してください。また、すべてのSaaSアプリがインテグレーションのためのオープンスタンダードに準拠しているわけではないため、相互運用性の低さにも注意が必要です。そのため、他のアプリと接続する際に問題が発生する可能性があります。

セキュリティについては、パブリッククラウドベースのSaaSアプリは、機密性の高いビジネスデータを転送する際のセキュリティが低く、セキュリティ、コンプライアンス、プライバシーの問題につながる可能性があります。

最後に、SaaSアプリは専門性の高いアプリであるため、万能なソリューションは存在しません。そのため、カスタマイズはオンプレミスのアプリに比べて困難です。

Sumo Logicは、クラウド規模でアプリケーションを運用し、セキュリティを確保するためのリアルタイムSaaSプラットフォームです。ここでは機械学習が重要な役割を果たします。Salesforceのような他のSaaSプラットフォームと簡単にインテグレーションすることができます。

Sumo Logic Continuous Intelligenceソリューションを使用すると、Salesforceのパフォーマンスをリアルタイムで監視できるだけでなく、セキュリティ侵害の可能性を迅速に特定して修正することができます。これは他のSaaSアプリにも当てはまります。

Platform as a Service(PaaS)は、開発者がカスタマイズしたアプリケーションを構築できるフレームワークを提供します。

PaaSの提供方法はSaaSとほぼ同じです。インターネットでソフトウェア機能を提供する代わりに、PaaSはソフトウェアを作成するためのプラットフォームを提供します。PaaSでは、企業はミドルウェアと呼ばれるソフトウェアコンポーネントを使って、PaaSに組み込まれたアプリケーションを設計・作成することができます。

PaaSを利用すると、アプリの開発、デプロイが簡単で低コストでできます。開発されたアプリは拡張性と可用性が高くなります。開発者はミドルウェアを気にすることなくアプリをカスタマイズすることができるため、開発スピードが速くなります。

仮想化技術により、必要に応じてリソースを簡単にスケールアップ/ダウンすることができます。PaaSは基本的にアプリケーションの開発、テスト、デプロイメントを支援するサービス群です。複数のユーザーが同じ開発プラットフォームを介してアクセスでき、Webサービスやデータベースとのスムーズなインテグレーションが可能です。

PaaSを使えば、開発のワークフローを効率化することができます。

PaaSは拡張性のあるカスタマイズされたアプリケーションのための素晴らしいプラットフォームを提供します。

PaaSを利用すれば、限られた予算の中でプラットフォームを持つことができ、コストを削減することができます。また、迅速なアプリ開発とデプロイも可能になります。

SaaSと同様に、PaaSにも制限や懸念事項があります。組織はPaaSソリューション上で独自のアプリを実行することができますが、データはPaaSベンダーによって管理されているサードパーティのサーバ上にあります。このため、データのセキュリティやプライバシーのリスクが懸念されます。

ベンダーロックインの可能性があり、ベンダーがしっかりとした移行ポリシーを持っていない場合、PaaSソリューションを切り替えるのは難しいかもしれません。

PaaSソリューションがあなたの選択したフレームワークや言語と互換性がない場合、ランタイムの問題が発生する可能性があります。PaaSソリューションが動作する言語やフレームワークのバージョンにも注意してください。

また、レガシーシステムをお持ちの場合には、レガシーシステム用にカスタマイズできないPaaSソリューションもありますので、注意が必要です。

Microsoft Azure Cloud は、Sumo Logic との連携が可能な PaaS ソリューションの一例です。Azure MonitorやEvent Hubとのインテグレーションは簡単です。Sumo Logicは Azure Audit、Network Inspector、SQL、Active Directory などのコンテンツの可視性を高めることもできます。

IaaS(Infrastructure as a Service)とは、コンピュータやストレージ、ネットワークなどへのアクセスや監視が可能なコンピューティングリソースのことです。追加でハードウェアを購入する必要はありません。

クライアントはIaaSベンダーからハードウェアをリースします。

提供は仮想化されたクラウドサーバを介して行われます。ダッシュボードやAPIを利用して、クライアントがインフラ全体を完全にコントロールできるようにします。IaaSはクラウド上の「仮想データセンター」をアウトソースしたものです。

SaaSやPaaSとは異なり、IaaSのクライアントはアプリケーションやオペレーティングシステムなどを管理する責任があります。しかし、サーバやハードドライブなどはIaaSプロバイダーが管理します。

IaaSは、ストレージ、ネットワーク、サーバ、処理能力をシンプルに配置した非常に柔軟性の高いクラウドコンピューティングモデルです。

IaaSのコストは様々ですが、基本的にはクライアントの利用量に依存します。クライアントはインフラを完全にコントロールすることができ、高いスケーラビリティから利益を得ることができます。

IaaSの特徴は、リソースをサービスとして提供するハードウェアインフラをリースすることです。前述の通り、利用量に応じてコストが変動します。

複数のユーザーが1つのハードウェアで作業することができます。そのため、非常に柔軟で拡張性の高い導入モデルとなっています。

スタートアップや小規模企業にとって、IaaSはハードウェアやソフトウェアを購入せずに開発が行える手段です。これにより、時間とコストを節約することができます。大企業や成長企業にとっては、現在のニーズに応じて特定のハードウェアやソフトウェアに切り替える必要があるため、IaaSはメリットがあります。

SaaSやPaaSと同様に、IaaSにも一定の制限や懸念点があります。

IaaSベンダーとクライアントは仮想マシンを介して接続されており、セキュリティが危うくなる可能性があります。複数企業で環境を共有するマルチテナントの場合、IaaSベンダーはクライアントのみが割り当てられたIaaSソリューションにアクセスでき、他のクライアントはアクセスできないようにしなければなりません。

PaaSと同様に、IaaSにもレガシーシステム用にカスタマイズできない可能性があります。

顧客はデータのセキュリティ、バックアップ、事業継続の責任を負うことになります。これには十分なトレーニングが必要であり、費用と時間がかかります。

前述の通り、サードパーティ製のインフラ(IaaS)をリースする際には、セキュリティが課題となります。そこでSumo Logicは、IT組織に提供するセキュリティ分析ツールを作成しました。

あらゆるクラウドデリバリーシステム(SaaS、PaaS、IaaS)に対応するために、Sumo Logicはクライアント向けのソリューションを用意しています。

本記事は米国Sumo Logic社のサイトで公開されているものをDigital Stacksが日本語に訳したものです。無断複製を禁じます。原文はこちらです。

" target="_blank">

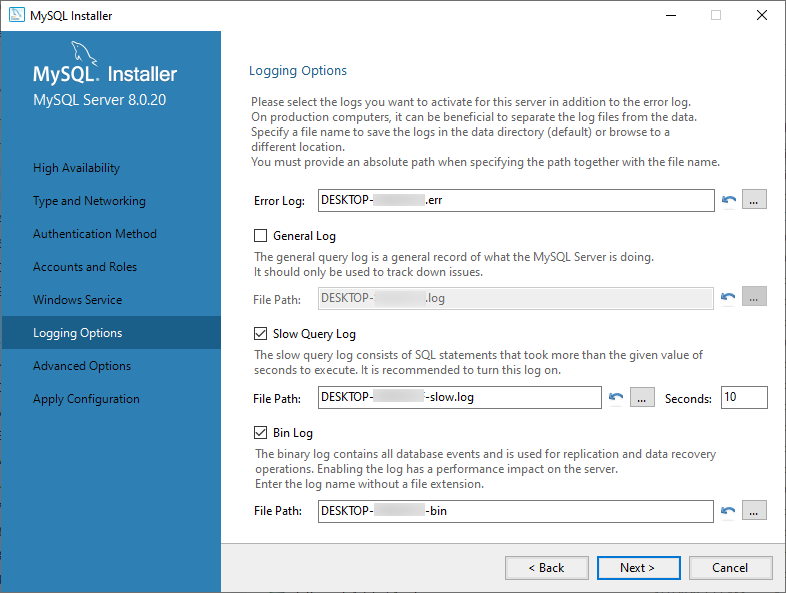

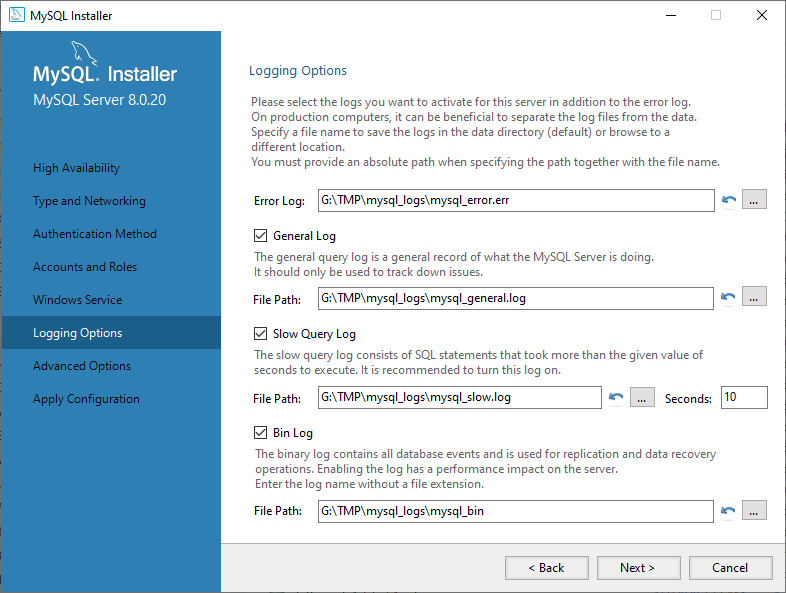

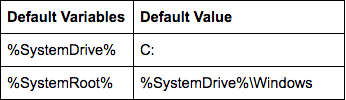

一般的なクエリ、低速クエリ、バイナリログはインストーラの GUI を通じて手動で有効/無効にできますが、エラーログはできません。また、各ログの名前とパスを手動で設定することもできます。

インストール後、ログの設定はユーザーが編集可能な C:¥ProgramData¥MySQL¥MySQL Server [バージョン]¥my.ini で管理されます。このファイルでログ名やパス、有効/無効を設定できます。

一般的なクエリ、低速クエリ、バイナリログはインストーラの GUI を通じて手動で有効/無効にできますが、エラーログはできません。また、各ログの名前とパスを手動で設定することもできます。

インストール後、ログの設定はユーザーが編集可能な C:¥ProgramData¥MySQL¥MySQL Server [バージョン]¥my.ini で管理されます。このファイルでログ名やパス、有効/無効を設定できます。

timestamp thread ID [error type] [error code] [MySQL subsystem] Error message text Error types include System, Warning, Note, and ERROR. Typical log entries might look like this: 2020-05-24T11:55:27.611014Z 0 [System] [MY-010116] [Server] /usr/sbin/mysqld (mysqld 8.0.20) starting as process 36070 2020-05-24T12:14:51.002836Z 2 [Note] [MY-010051] [Server] Event Scheduler: scheduler thread started with id 2 2020-05-24T12:41:45.059924Z 0 [Warning] [MY-010068] [Server] CA certificate ca.pem is self signed. 2020-05-24T12:41:45.086628Z 0 [ERROR] [MY-011825] [InnoDB] Failed to delete file ./#innodb_temp/temp_7.ibtエラーログは常に有効で、利用可能なオプションでは、ログ出力先、冗長レベル、タイムゾーンを設定することができます。 可能なエラーログの出力先は、ファイルまたはコンソールです。Windows では出力先オプションが指定されていない場合、エラーログはデータディレクトリの host_name.err(host_name はホストシステム名)に書き込まれます。UNIX/Linux システムでは、オプションが指定されていない場合のデフォルトの保存先はコンソールです。 UNIX/Linux と Windows ベースの MySQL の両方のインストールでは、--log-error オプションを指定すると(ファイル名やパスを指定せずに)、エラーログを Data ディレクトリの host_name.err に送信します。 --log-error='G:¥TMP¥mysql_logs¥mysql_error.err' や、 --log-error=/var/log/mysql/error.log のようにファイル名とパスを指定すると、エラーログは指定されたファイルに書き込まれます。Windows のコンソールにエラーログを送信するには --console オプションを使用する必要があります。

2020-05-26T08:01:39.429740Z 17 Query INSERT INTO rental VALUES (1,'2005-05-24 22:53:30…同じイベントの低速クエリログのエントリは、次のようになります。

# Time: 2020-05-26T08:01:50.095050Z # User@Host: root[root] @ localhost [::1] Id: 17 # Query_time: 10.699002 Lock_time: 0.037315 Rows_sent: 0 Rows_examined: 0 use sakila; SET timestamp=1590480099; INSERT INTO rental VALUES (1,'2005-05-24 22:53:30…遅いクエリログでは、実行に異常に長い時間を必要とするクエリを特定することができます。一般的なクエリログでは、すべてのクライアントのSQL文を追跡することができ、エラーの追跡や潜在的なセキュリティ問題の特定に役立ちます。 クエリログはデータを急速、大量に蓄積することがあるため、ディスク容量を消費するだけでなく、システムのパフォーマンスにも影響を与える可能性があります。特に一般的なクエリログは非常に速く増える可能性があり、ほとんどのインストールパッケージではデフォルトでクエリログと低速クエリログの両方が無効になっています(ただし、Windows MySQL インストーラは例外で、上述の通りです)。 一般クエリログと低速クエリログは、--general-log と --slow-query-log オプションを使用して別々に有効化します。デフォルトの出力先はデータディレクトリで、ファイル名は[ホスト名].log と [ホスト名]-slow.log です。ログ名とパスを設定するには、--general-log-fileと--slow-log-fileオプションを使用します。 両方のログの形式は、単一のオプション --log-output で制御され、FILE、TABLE、またはNONEの値をとり、FILEがデフォルト値です。TABLE は両方のログをテーブルとして保存し、SQL クエリで読み込んで管理することができます。FILEとTABLEはカンマで区切って一緒に使用することができます。NONE は、両方のログの出力を無効にします。

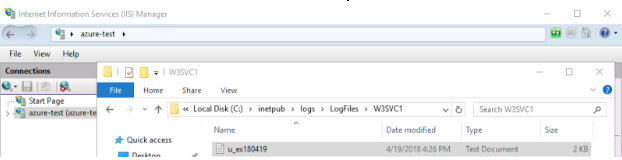

LogFilesディレクトリ内には、IISマネージャー管理コンソールでセットアップされたすべてのWebサイトやアプリケーション用に作成されたフォルダがあります。

デフォルトのサーバログフォルダはW3SVC1です。追加のフォルダは「1」をより長い乱数に置き換えます。デフォルトでは、「formatDDMMYY.log」というファイル名でNCSA、Extended、あるいはIISのフォーマットで新しいアクセスログファイルが毎日作成されます。LogFilesディレクトリ内には、IISマネージャー管理コンソールでセットアップされたすべてのWebサイトまたはアプリケーション用に作成されたフォルダーがあります。

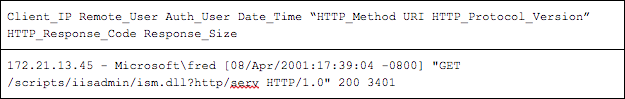

下はWebサイトとログフォルダとファイルの例です。

LogFilesディレクトリ内には、IISマネージャー管理コンソールでセットアップされたすべてのWebサイトやアプリケーション用に作成されたフォルダがあります。

デフォルトのサーバログフォルダはW3SVC1です。追加のフォルダは「1」をより長い乱数に置き換えます。デフォルトでは、「formatDDMMYY.log」というファイル名でNCSA、Extended、あるいはIISのフォーマットで新しいアクセスログファイルが毎日作成されます。LogFilesディレクトリ内には、IISマネージャー管理コンソールでセットアップされたすべてのWebサイトまたはアプリケーション用に作成されたフォルダーがあります。

下はWebサイトとログフォルダとファイルの例です。

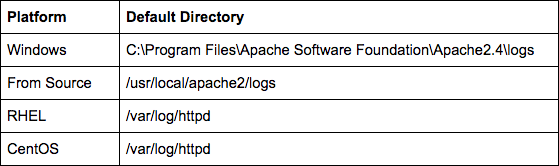

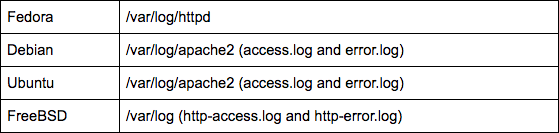

ほとんどのディストリビューションのパッケージ版Apache HTTPを使用する場合、ファイルは/var/log/httpdにあります。デフォルト設定を使用してソースからコンパイルする場合、ログファイルは$PREFIX/logsにあります。$PREFIXはコンパイル中に設定でき、デフォルトの場所は/usr/local/apache2です。

ほとんどのディストリビューションのパッケージ版Apache HTTPを使用する場合、ファイルは/var/log/httpdにあります。デフォルト設定を使用してソースからコンパイルする場合、ログファイルは$PREFIX/logsにあります。$PREFIXはコンパイル中に設定でき、デフォルトの場所は/usr/local/apache2です。

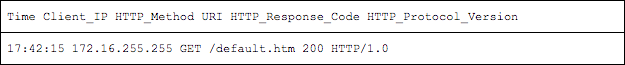

IIS形式は、3つの形式の中で最も情報が多く、時間ベースやサイズベースなど、複数の種類のファイルローテーションをサポートしています。

IIS形式は、3つの形式の中で最も情報が多く、時間ベースやサイズベースなど、複数の種類のファイルローテーションをサポートしています。

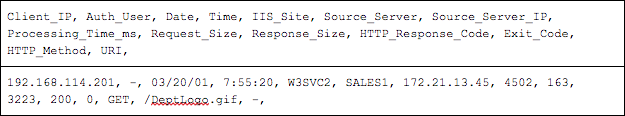

NCSAはApache HTTP、NGINXや他のいくつかのWebサーバで使用される形式です。他の2つのテキストオプションと比較して、データのバランスが良い構文を持っています。

NCSAはApache HTTP、NGINXや他のいくつかのWebサーバで使用される形式です。他の2つのテキストオプションと比較して、データのバランスが良い構文を持っています。

この記事を読んでいる方は、おそらく1980年代から使用されているロギングツールであるsyslogに精通していることでしょう。ほとんどのLinuxベースのオペレーティングシステムに存在するデーモンです。

デフォルトでは、Linuxシステムのsyslog(およびrsyslogなどの派生アプリ)を使用して、ログをsyslogサーバや監視プラットフォームに転送して、さらに分析を行うことができます。これは便利ですが、syslogを最大限に活用するには、ログデータを分析できるようにする必要もあります。

そこで、ここではローカルのシステムログを取得し、Sumo Logicコレクターを使用してSumo Logicに転送するプロセスを説明します。

また、syslogやrsyslogデーモンを使用して、サーバからログを送信する方法も示します。

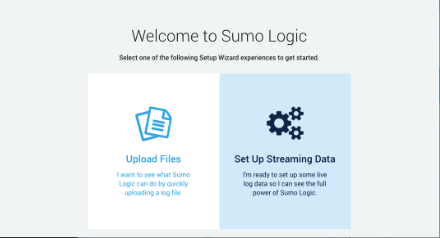

ログをSumo Logicにストリーミングできるようにするには、まずパッケージにサインアップする必要があります。有料のオプションもありますが、Sumo Logicのテストとして、ストリーミングするログの量を少なくし、1日最大500Mバイトまでならば無料で使えるオプションがあります。サインアップすると、次のようなページが表示され、ログファイルをアップロードするか、ストリーミングログにすぐにジャンプするかを選択します。ここでは後者のオプションを選択します。

「Set Up Streaming Data」ボタンをクリックすると、Linux、Windows、あるいはMacからAWS環境をすぐに開始できるオプションが表示されます。

今回はLinuxを選択します。これにより、次のような簡単なコマンドでSumo Logicコレクターをデプロイできます。

sudo wget 'https://collectors.de.sumologic.com/rest/download/linux/64' -O SumoCollector.sh && sudo chmod + x SumoCollector.sh && sudo ./SumoCollector.sh -q -Vsumo.token_and_url=<unique_token>

コマンドを実行すると、コレクターがインストールされ、Sumo Logicに自動的に登録されます。この時点で、「Continue」をクリックできるようになります。

次に、データのソース情報を設定します。まず、ソースカテゴリーを設定します。これは、収集時に各メトリックの時系列に追加されるメタデータタグです。希望する任意の名前を設定できます。これを使用して、将来このソースからのメトリックを見つけることができます。

プロセスのこの時点で、データを収集するログファイルを設定することもできます。デフォルトでは、/var/log/secure*と/var/log/messages*がスクレイピング用に選択されています。もちろん、収集したい他のログファイルを追加できます。例えば、実行中にアプリが生成するログファイルです。

最後に、ログファイルのタイムゾーンを使用するか、無視して別のタイムゾーンを使用するかを選択できます。これで、「Continue」をクリックする準備ができました。ログのサイズが大きい場合には、Collectorが設定とデータを追加する間にコーヒーが1杯飲めるかもしれません。

完了すると次のように表示されます。

では、楽しい作業に移りましょう。ログを表示して、情報を検索します。「Linux System」という名前のページの上部にあるサンプル検索オプションを使用すると、サーバからストリーミングされたログを表示できます。「sumologic」という名前のログも含めるように検索クエリを修正しました。これがその結果です。

ホスト名、データ取得元のログファイル名、セットアップ中に設定した「linux/system」というカテゴリーが表示されます。

また、ログイン時に一般的な情報を表示できる便利なダッシュボードもあります。もちろん、ログの情報に基づいてこれを変更し、新しいグラフを追加できます。これは、アプリケーションのHTTPエラーの詳細など、さまざまな機能に使用できます。たとえばメールサーバならば、バウンスや拒否されたメールの数を表示できます。

Syslogソースを追加するには、Sumo Logicコントロールパネルで新しいソースを設定します。これを行うには、「Manage Data」→「Collection」→「Collection」に移動します。次に、「Add」→「Add Source」→「Syslog」をクリックします。ここでは、プロトコル(TCPまたはUDP)とポート番号とともにsyslog名を指定します。この記事では、ポート1514でUDPを選択しました。linux/syslogのソースカテゴリーを使用することにしました。ここで「Save」をクリックします。コレクターがサーバのUDPポート1514をリッスンしているサービスが表示されます。

この時点で、コレクターの新しいリスナーにログを送信するようsyslogを設定する準備が整いました。設定にはsyslogまたはrsyslogの設定ファイルを編集します。この場合、後者は/etc/rsyslog.confです。このログファイルの最後に、コメントアウトされた行があります。

# remote host is: name/ip:port, e.g. 192.168.0.1:514, port optional

#*.* @@remote-host:514

# ### end of the forwarding rule ###

この行のコメントを外し、IPアドレスとポートを変更して、rsyslogが保持するすべてのログ(*.*)を新しいリスナーに送信します。

# remote host is: name/ip:port, e.g. 192.168.0.1:514, port optional

*.* @127.0.0.1:1514

# ### end of the forwarding rule ###

ログ送信にTCPではなくUDPを使用するようにrsyslogに指示する「@」をIPアドレスの先頭に付加してください。

ここで説明したアプローチを採用する理由は次の通りです。

組織内の中央syslogサーバにコレクターをセットアップし、すべてのログをSumo Logicに転送することができます。このアプローチの利点は、すべてのサーバに個別にコレクターをインストールする必要がないため、非常に多くのソースからのトラフィックを許可するために企業のファイアウォールを開ける必要がないことです。

Sumo Logicは、大規模な組織に存在する可能性のある制限を回避するために、リスナーを独自の環境に拡張できる包括的なクラウドソリューションを提供します。これにインターフェイス、合理化されたセットアッププロセス、ダッシュボードを組み合わせることで、非常に競争力のあるソリューションとなり、ログを積極的に監視し、お客様に影響を与える前に問題を発見できます。

キース・ロジャースは、10年以上の経験を持つITプロフェッショナルで、現在は英国の大手放送会社で働いています。彼の長年にわたるコンピューティングへの情熱は、いくつもの業務外の活動をうながし、彼の知識を深め関心を高めることにつながりました。

キースは長年Linux上でApache、MySQL、PHPを使用して完全なWebスタックを構築し、高可用性に適したより複雑な負荷分散と冗長ソリューションを作成してきました。過去2、3年、彼はAWSやAzureが提供する新しいクラウドベースのインフラストラクチャを使用して、同様の目標を達成しています。

" target="_blank">